安裝XGBoost,試著替換掉隨機森林看Kaggle分數會不會比較高

XGBoost安裝與如何使用

(py36)$brew --version

版本太舊的話brew update

沒有的話/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)"

(py36)$install gcc --without-multilib

(py36)$brew install llvm

(py36)$brew install clang-omp

如果找不到clang-omp

(py36)$brew install --with-clang llvm

(py36)$pip install xgboost

到這步XGBoost就裝好了

接下來是程式部分:

完整程式碼

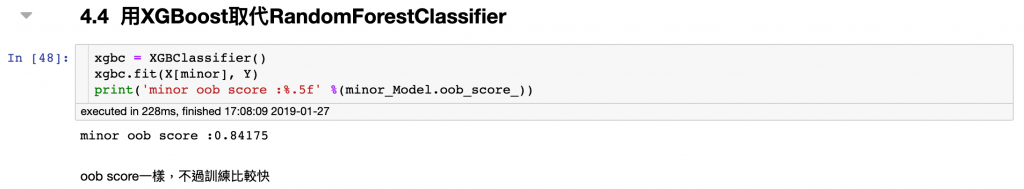

資料處理都相同,演算法取代隨機森林後Kaggle分數是0.81818,分數沒有比較高,但跟隨機森林0.82296比差距不大,我們也知道算法選擇跟分數有很大相關

我想可能因為是否生存是二分類問題,而樹狀結構正好適合處理

順帶一提,Kaggle也有很棒的學習資源,可以參考這裡

可以用SVM或其他算法試試嗎?

如何選擇對問題合適算法?

https://zhuanlan.zhihu.com/p/23996104